Die Entwicklung Künstlicher Intelligenz schreitet rapide voran – und mit ihr die Möglichkeit, sie für Autonome Waffensysteme zu nutzen. Eine Kooperationsveranstaltung der Heinrich-Böll-Stiftung, des Auswärtigen Amtes und der Bundesakademie für Sicherheitspolitik nahm Risiken und Kontrollbedarfe dieser Technologie in den Blick.

Zahlreiche Teilnehmerinnen und Teilnehmer folgten der Einladung in die Heinrich-Böll-Stiftung zur Diskussion über Künstliche Intelligenz und Autonome Waffensysteme. Foto: BAKS/Adamzik.

Noel Sharkeys Alptraum fährt durch Videos, die aussehen wie Computerspiele. Ganz von selbst rollen mehrere Panzer in Formation durch eine Stadt, finden ihre Ziele und bekämpfen sie – und all das ohne menschliches Zutun. Noch gibt es die Panzer aus dem Video nicht. Aber angeblich arbeiten Ingenieure daran – eine Horrorvorstellung für Sharkey, emeritierter Professor für Künstliche Intelligenz der Universität Sheffield und Sprecher der Internationalen Kampagne gegen Killer-Roboter. Das Video kommt zwar aus Russland, führend bei der Entwicklung Autonomer Waffen sind aber andere Staaten. Ganz vorne spielen China und die USA mit. Mit dem Ziel, die Diskussion zu versachlichen, nahmen die Heinrich-Böll-Stiftung, das Auswärtige Amt und die BAKS in einer gemeinsamen Expertenrunde mit angeschlossener öffentlicher Podiumsdiskussion die potentiellen Auswirkungen Künstlicher Intelligenz auf die internationale Sicherheit und die Möglichkeiten zu ihrer Kontrolle in den Blick.

Künstliche Intelligenz – ein Heilsversprechen der Industrie?

In Flugabwehrsystemen wie zum Beispiel PATRIOT finden autonome Elemente bereits Anwendung.

Foto: Bundeswehr/Nurgün Ekmekcibasi.

Dabei ging es zwar um Waffen, aber nicht nur um das Militär. Bei Forschung und Entwicklung sei im Bereich Künstliche Intelligenz (KI) vor allem ein Akteur ausschlaggebend: „Der Haupttreiber ist die Industrie“, sagte Professor Hans Uszkoreit vom Deutschen Forschungszentrum Künstliche Intelligenz. Diese Industrie befinde sich vor allem in den USA und China. Von den rund 50 maßgeblichen Forschungseinrichtungen seien zwar 28 in Europa und diese seien gut in der KI-Grundlagenforschung. Aber mit der Umsetzung in konkrete Anwendungen hapere es hierzulande, auch im zivilen Bereich.

Doch auch, wenn die Industrie in der Entwicklung vorne ist – die Streitkräfte der Welt sind keine unbeteiligten Beobachter. Denn theoretisch biete Künstliche Intelligenz auch im militärischen Bereich große Chancen. KI könne den Streitkräften helfen, schneller und effizienter zu werden, so die Einschätzung eines Militärexperten bei der Tagung. Bereits heute spielt Autonomie in manchen Waffensystemen eine Rolle – insbesondere dort, wo alles sehr schnell gehen muss, wie etwa bei Flugabwehrsystemen, die mit mehrfacher Schallgeschwindigkeit anfliegende Raketen und Geschosse abfangen können. Zum Einsatz Autonomer Waffen zu solchen Abwehrzwecken meinte auch Sharkey: „Ich habe keinerlei Probleme damit.“ Dieselbe Technologie könne aber auch in anderen Waffensystemen eingesetzt werden, um menschliche oder bemannte Ziele ins Visier zu nehmen – und dann werde es sehr wohl problematisch.

Zu intelligent? Das Gegenteil könnte der Fall sein

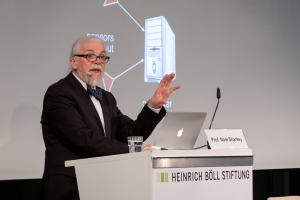

Noel Sharkey stellte die Risiken Autonomer Waffensysteme heraus. Foto: BAKS/Adamzik.

„Niemand verdient es, von einer Maschine getötet zu werden“, formulierte Sharkey zudem einen fundamentalen ethischen Einwand. Dazu kämen technologische Schwächen: „Alles, was man sich ausdenken kann, kann man auch manipulieren.“ Ein grundlegendes Problem, darin waren sich die meisten der Expertinnen und Experten bereits auf der Tagung einig, sei dabei nicht, dass die Waffen „zu intelligent“ wären – vielmehr sei das Gegenteil der Fall.

„Wir sind noch nicht gut genug“, sagte Sharkey mit Blick auf die Fähigkeit von Computern, in komplexen Entscheidungssituationen menschlicher Handlungskompetenz nahe zu kommen. Autonome Waffen seien gar nicht in der Lage, in dynamischen Kampfsituationen völkerrechtskonform zu handeln und Kombattanten von Zivilisten oder Kämpfende von Verwundeten zu unterscheiden. Auch die Verhältnismäßigkeit eines Angriffs einzuschätzen, sei „unmöglich für eine Maschine.“ Eine entscheidende Frage blieb somit, wie die tatsächliche menschliche Kontrolle über das Maschinenhandeln – im Fachjargon „meaningful human control“ genannt – künftig aufrechterhalten werden kann.

Ist eine Ächtung Autonomer Waffen realistisch?

Die Bundestagsabgeordnete Agnieszka Brugger forderte mehr Engagement der Bundesregierung für die Ächtung Autonomer Waffen.

Foto: BAKS/Adamzik.

Für Sharkey ist die einzige Lösung ein Verbot. Rüdiger Bohn aus dem Auswärtigen Amt sagte, dass die völkerrechtliche Ächtung von Systemen, die sich der menschlichen Kontrolle entziehen, ein „klares Ziel der Bundesregierung“ sei. Bei den Vereinten Nationen setze Berlin sich für eine politische Erklärung gegen Autonome Waffensysteme ein. Rechtlich bindend wäre die zwar nicht, griff Bohn die Kritik an der deutschen Position auf. Aber da mehrere große Staaten bei einem Verbot nicht mitzögen, sei die politische Erklärung im Moment die einzige Option. „Wir wollen ja nicht einfach eine Ächtung von Autonomen Waffensystemen, sondern eine weltweite Ächtung“, so Bohn.

Für die Bundestagsabgeordnete Agnieszka Brugger von Bündnis90/Die Grünen war das zu wenig. „Ich fände es tausendmal besser, wenn Deutschland da eine klare Position hätte“, so die Stellvertretende Fraktionsvorsitzende. Auch Sharkey gab sich kritisch: „Während Sie mit Verträgen herumspielen, entwickeln die anderen diese Sachen schon“. Möglich, dass er dabei auch an die selbst fahrenden Panzer aus dem Propagandavideo gedacht hat.

Autorin: Katharina Münster